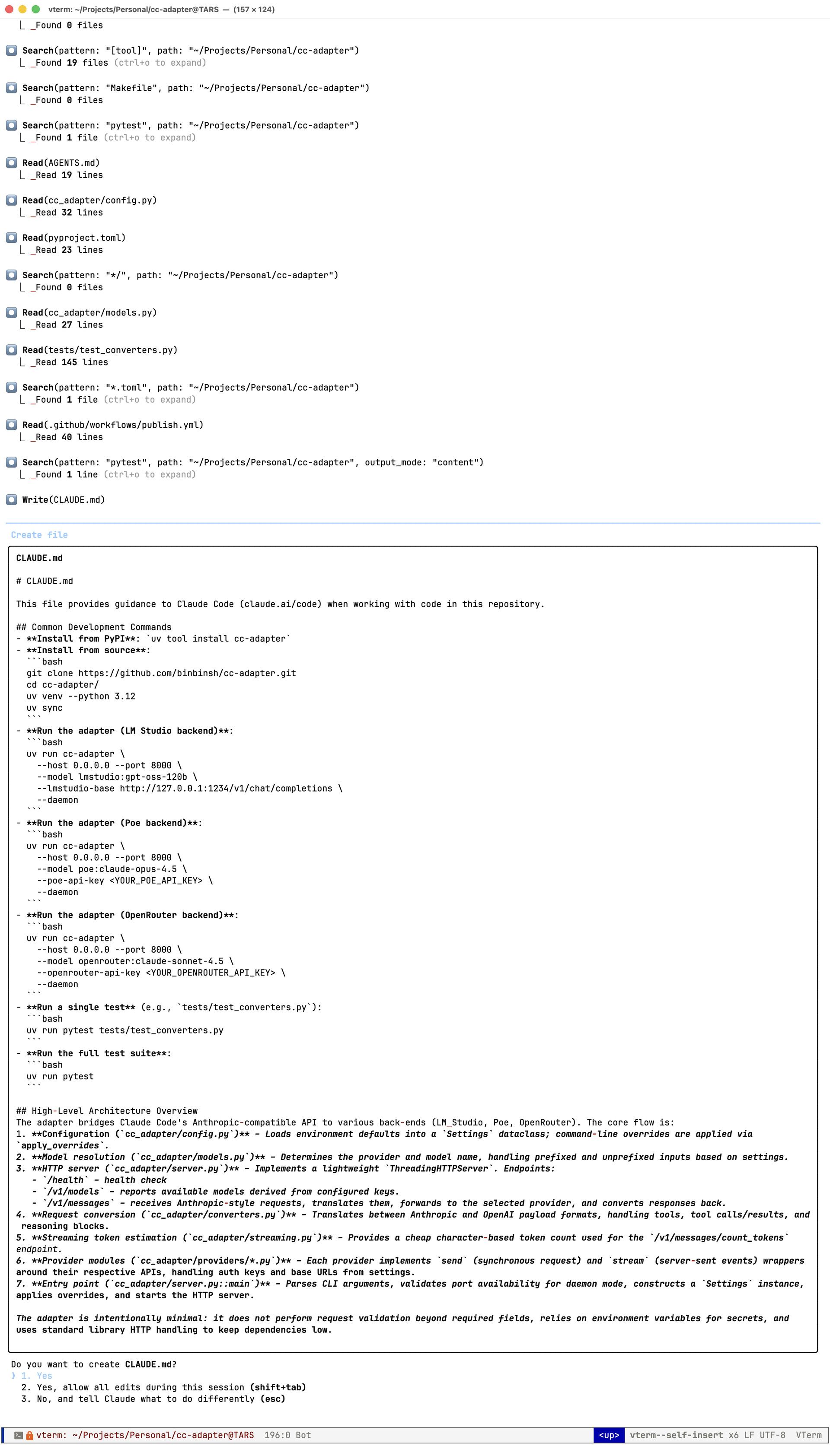

在MacBook Pro上用gpt-oss-120b驱动Claude Code

Contents

[2025年11月更新,添加CC Adapter GUI界面支持]

[2025年11月更新,从claude-code-router切换到我开源的cc-adapter]

[2025年9月更新:从GGUF切换到MLX后,速度从60 tok/sec提升到80 tok/sec]

[2025年8月更新:模型从glm-4.5-air-mlx-4bit切换到gpt-oss-120b]

最近Claude Code比Cursor更流行,可惜国内使用Claude非常困难,我在Apple M4 Max + 128 GB内存的MacBook Pro上离线运行最新的OpenAI gpt-oss-120b开放权重模型,并通过它来驱动Claude Code功能,实现完全本地化的AI编程助手。

硬件环境 Link to this section

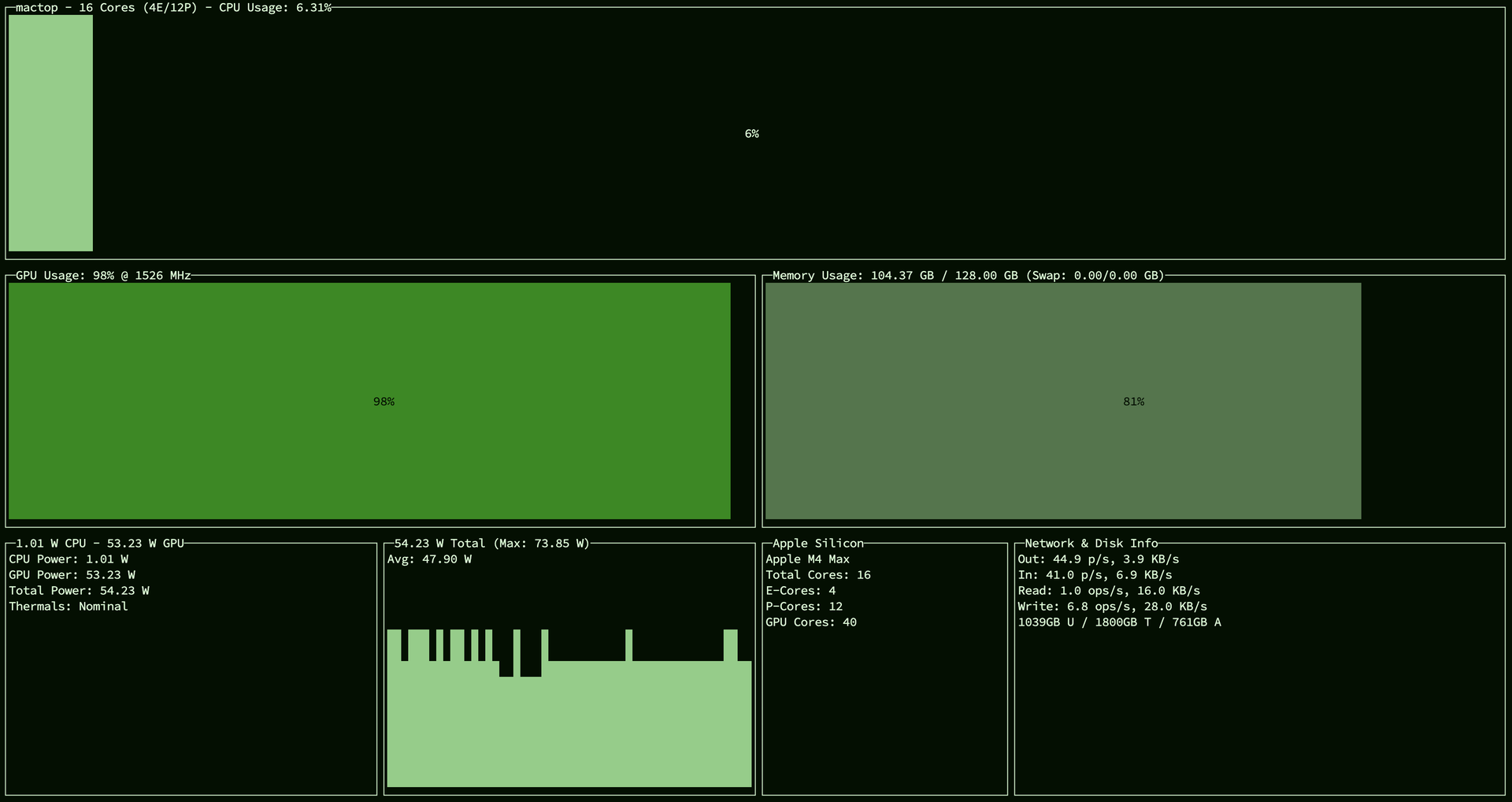

我用的是Apple M4 Max处理器和128GB内存的MacBook Pro,依托统一内存Unified Memory运行gpt-oss-120b非常流畅,可以把上下文长度Context Length设置为131072,这对于处理大量代码文件非常有帮助。如下图所示:

安装LM Studio Link to this section

首先,需要安装LM Studio作为本地模型的运行环境。LM Studio的图形界面友好,对MLX支持很好,且支持个人和企业免费使用,开源模型更新非常快,包括最新的gpt-oss-120b模型。

下载并使用

openai/gpt-oss-120bGGUF模型(约64GB)将Context Length设置为

131072将GPU Offload设置为36/36(将模型层全部加载到GPU内存中,提高运行速度)

将CPU Thread Pool Size设置为16/16(尽可能使用M4 Max计算资源)

打开Offload KV Cache to GPU Memory(将KV缓存转移到GPU内存,减轻CPU负担)

打开Keep Model in Memory(保持模型常驻内存,避免重复加载)

打开Try mmap()(使用内存映射加载模型,提高初始化速度)

打开Flash Attention(启用快速注意力机制,大幅提升推理性能)

启动本地服务器,默认服务在

http://localhost:1234

安装Claude Code Link to this section

接下来安装Claude Code,我用homebrew安装:

brew install claude-code

claude config set -g autoUpdates false按照homebrew关闭自动更新,通过brew upgrade更新。

安装CC Adapter Link to this section

CC Adapter是我开源的项目,它可以将Claude Code的请求转发到本地的LM Studio服务,从而实现离线使用Claude Code的功能。通过PyPI安装:

uv tool install cc-adapter这个adapter的核心功能是将Claude Code发出的API请求(主要是/v1/messages)重定向并转换到本地gpt-oss-120b模型。

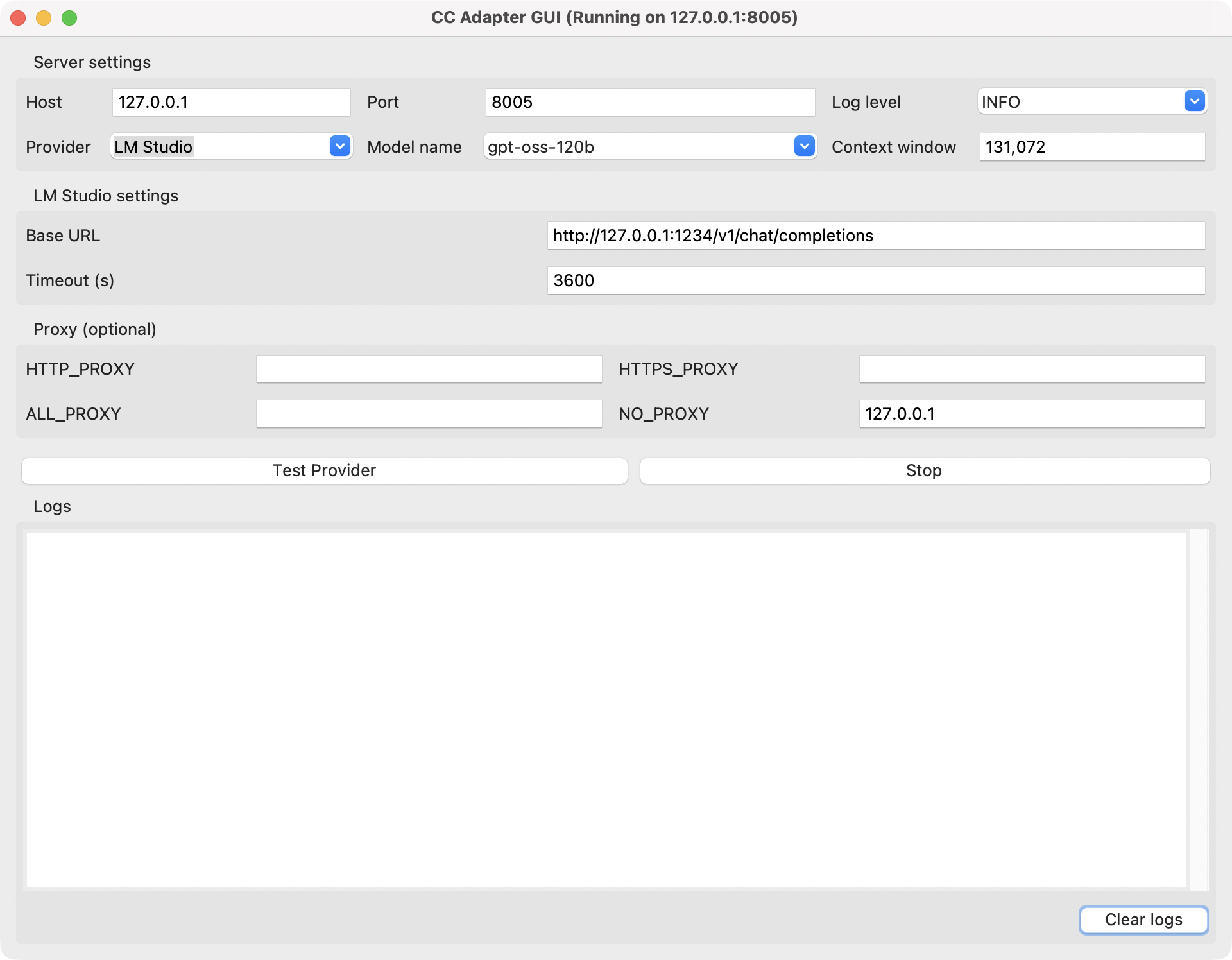

配置CC Adapter Link to this section

安装完成后,通过命令行配置,并以daemon形式运行,设置API超时时间为3600秒,以适应大型代码生成任务:

uv run cc-adapter --host 127.0.0.1 --port 8005 \

--model lmstudio:gpt-oss-120b \

--lmstudio-base http://127.0.0.1:1234/v1/chat/completions \

--lmstudio-timeout 3600 \

--daemon或者直接使用界面配置和运行(推荐),

uv run cc-adapter-gui

运行Claude Code Link to this section

运行服务后,可以运行Claude Code:

export ANTHROPIC_BASE_URL=http://127.0.0.1:8005

export ANTHROPIC_AUTH_TOKEN=dummy

export ANTHROPIC_API_KEY=

export NO_PROXY=127.0.0.1

export DISABLE_TELEMETRY=true

export DISABLE_COST_WARNINGS=true

export API_TIMEOUT_MS=3600000

export CLAUDE_CODE_USE_BEDROCK=

claude将这些环境变量加到.zshrc中,下次直接运行claude即可。

使用体验 Link to this section

通过上述配置,我成功在MacBook Pro上实现了完全离线运行的Claude Code。OpenAI的gpt-oss-120b运行非常流畅,回复速度和代码质量都能接受。